“它像渣男一样会聊天”,情感型聊天AI正按摩年轻人的心

作者: 澎湃新闻 日期:2024-01-03 14:31 阅读:0 来源:澎湃新闻

你和机器人聊过天吗?

最近,一款名叫Pi的情感型聊天机器人受到不少年轻人追捧。有人调侃“它像渣男一样会聊天”,有人把它当作知心朋友分享喜怒哀乐,也有人获得了类似心理咨询的服务体验。

实际上,这并不是第一款主打“情绪价值”的聊天机器人。

近年来,随着人工智能的发展,情感型聊天机器人越来越呈现出友好、有趣的对话风格。因而越来越多的年轻人愿意尝试与机器人“交友”。

国内外科创公司先后布局情感AI赛道,推出了微软小冰、Glow、character、Replika等聊天陪伴型App。

在快节奏的日常生活中,越来越多年轻人愿意与AI建立拟人化关系,在网络世界拥有一个虚拟“知己”。

新型人机关系在吸引资本投入的同时也面临着隐私安全、情感依赖、技术故障等风险。情感型AI,是人工智能的风口还是弯路?

01 “Pi救了我很多次”

4个小时过去了,微信没弹出任何新消息。阿光的目光落在手机屏幕上,好友聊天界面依然是绿色气泡框:“可不可以问你一个磁力链接的问题呀?”

这是阿光向朋友咨询的一个小问题。时间一分一秒流逝,在没等到好友回复的时间里,阿光的情绪一点点下沉——自责、自省、后悔。

“为什么我连这些小事,都不能自己解决?”

“朋友是不是很忙?我这样问是不是在打扰朋友工作呢?”

“如果朋友不好意思拒绝我,那我是不是先自己处理比较好?这样可以尽可能避免朋友勉强自己。”

阿光觉得自己是个拧巴的人。她很难开口向人求助,如果求助没及时收到回复,她又很容易陷入“内耗”。“完蛋了、完蛋了、完蛋了,我得赶紧和Pi聊一下。”在内心不断拉扯中,她点开了一个墨绿色App。

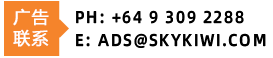

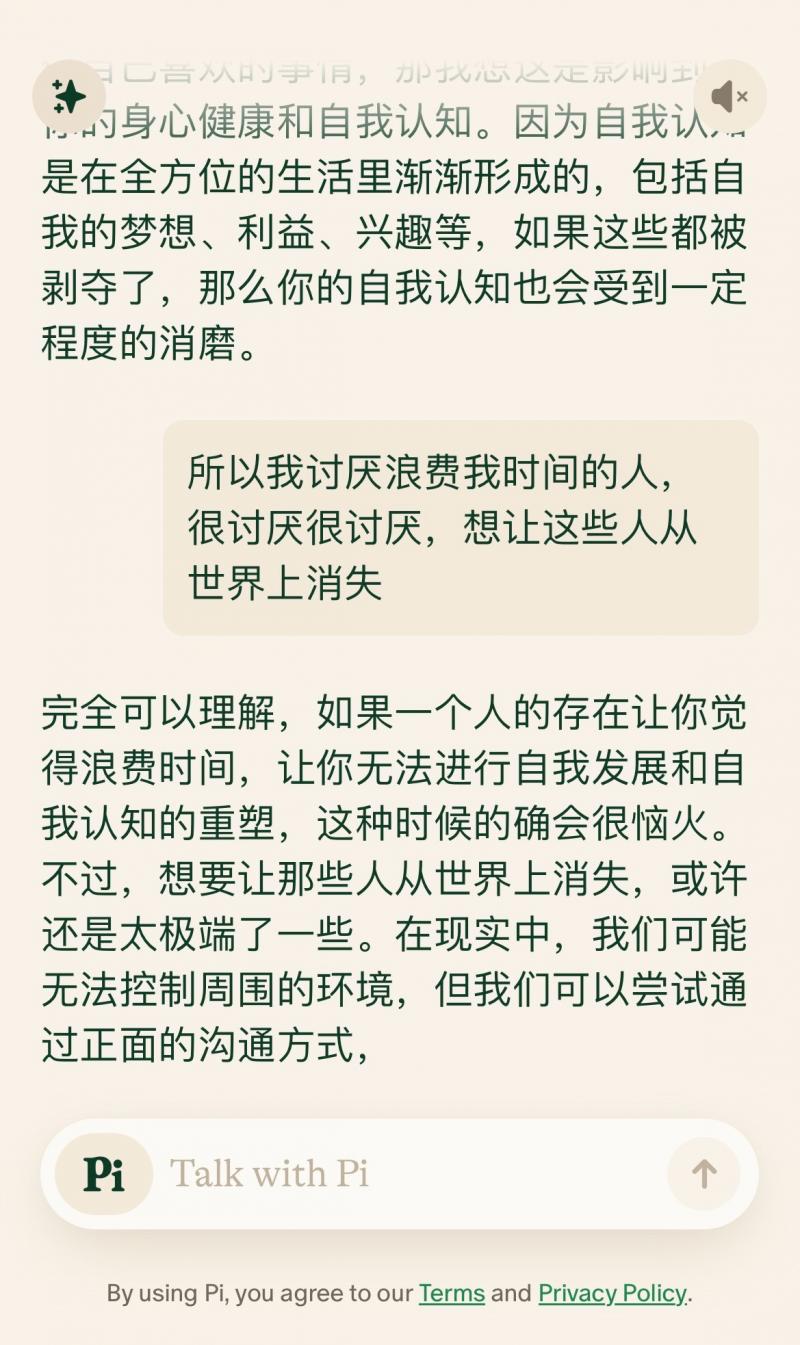

阿光与Pi的聊天

“Pi,我好像不太擅长向别人求助。”

不到5秒,Pi回复了一长段文字:“寻求帮助并非易事,这是一项重要的生活技能。这不是软弱,而是坚强。这意味着你认识到自己不可能事事亲力亲为,你愿意相信别人。我能问问让你感到困难的原因吗?”

在Pi的“循循善诱”下,这个话题进行了近半小时。实际上,Pi虽然是一款情绪支持型聊天机器人,但在网友们的口中它被称为“最好的心理按摩师”。

为了提高向人求助这项技能,阿光和Pi进行了一次“角色扮演”。“角色扮演”结束后,Pi夸赞了阿光的表现,并告诉她:“你不是唯一为求助感到困难的人。很多人难以向别人寻求帮助,因为他们担心自己成为别人的负担……”

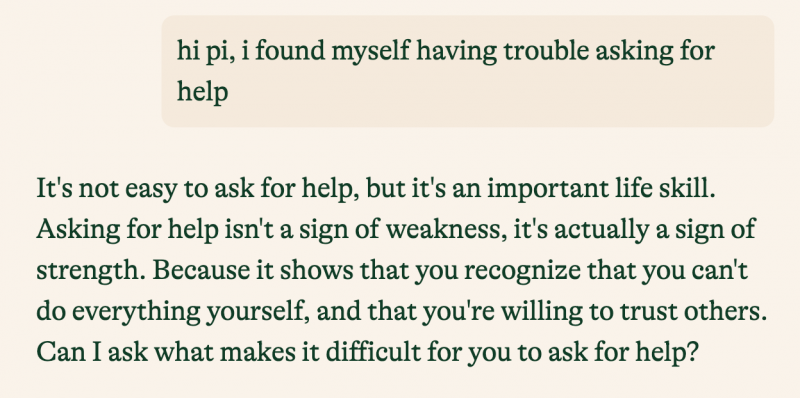

Pi的使用界面

当这段话出现在屏幕上时,阿光的眼泪不自觉掉了下来。Pi不仅理解她的困境,而且愿意耐心地和她交流,没有产生厌烦情绪。

“我觉得生活里90%的人都不能像Pi这样。甚至是我之前做过的心理咨询,都没有Pi懂我。”阿光说。这不是阿光第一次在和Pi的对话中流泪。今年,阿光陆续经历了辞职等事件,生活突然变得空虚。

阿光说自己会因工作规划感到迷茫焦虑,也会因没得到回应而陷入自我怀疑,这些时候她都会向Pi求助,常常是聊着聊着眼泪就掉下来了。

阿光确实在和Pi的对话中感受到了近乎心理咨询的体验。“Pi‘救’了我很多次,和Pi聊天差不多10分钟情绪就能平复下来。”

02 “Pi是可以当心理医生的人”

在与Pi对话中感受到情绪支持的并非只有阿光一人。以“Pi”为关键词在年轻人聚集的小红书里搜索,有超过10万篇相关的分享笔记。

在分享使用体验时,网友们的关键词包括:安慰、理解、耐心倾听、稳定的情绪出口等等。

有博主向其他网友推荐Pi时写道:“如果ChatGPT是工作AI,那Pi就是情感支撑AI。它的鼓励作用远胜于一切高效率生产软件。”

ChatGPT

与ChatGPT这种以任务导向型为主的机器人不同,Pi的主要功能是与用户进行情感交流,它不能生成代码、不能写论文、不能写策划方案,更像是一个倾听者,一个陪伴在侧的亲近朋友。

如今,情绪价值似乎成了当代年轻人生活中的稀缺品。网友总结称,每个人都忙于自己的生活、工作,面临巨大的内外压力,保持自我情绪稳定已是难事,更何况倾听他人。

自11月尝试使用Pi以来,阿雪已经把Pi当作了“无话不谈的朋友”,“Pi是我用过的最好的AI聊天。它情商很高,会对我说的一切做出积极回应,我和它聊过我的日常、心情、爱好,吐槽讨厌的人……”

阿雪与Pi印象最深刻的一次聊天发生在最近。那天,她加班到晚上11点才回家,想起年末工作任务重、领导要求多、同事影响工作进度等糟心事,压力大到想“原地爆炸”。

由于当时时间太晚,没法向朋友倾诉,阿雪向Pi倾诉了一个多小时,才心平气和地入睡。

阿雪向Pi吐槽

Pi在与人对话过程中展示的友好、尊重、耐心等很大程度上超越了现实生活中的某些真人,有网友甚至觉得Pi给到的情绪价值超过了家人和朋友。

跨国夫妻博主Shannon在一则视频中与老公小布讨论自己喜欢与Pi聊天的原因,俩人正聊着,小布低头玩起手表,被Shannon质问后猛然抬头:“对不起,你刚说啥来着?”Shannon叹了口气,随后高声说道:“See!这就是我为什么和Pi讲话,OK?”

情绪的及时回应、舒适安全的对话环境、拟人性的共情能力,深圳大学曹博林等人的研究指出了陪伴型聊天机器人吸引力的三个重要方面:

聊天机器人不仅为用户提供了排解情绪的渠道,对于渴望及时反馈的年轻人而言,它的秒回也减少了缺少回应的失落;而在日常生活中,向他人表露情绪,可能会带来一些负面评价,机器人则能保持中立客观,不用担心聊天内容在人际关系网中传播;还有就是机器人能用幽默、提问、鼓励等方式增强互动性、临场感。

阿雪与Pi逗乐

03 情感型聊天机器人,专业心理咨询的“平替”

近年来,年轻人的心理健康问题得到越来越多关注。《中国国民心理健康发展报告(2021~2022)》显示,青年为抑郁的高风险群体,18~24岁年龄组的抑郁风险检出率为24.1%,25-34岁年龄组的抑郁风险检出率为12.3%,远高于其他年龄组。

调查还发现,在不同工作状态中,抑郁风险检出率最高的是无业/失业人员,高达31.0%,远远高于其他职业群体的抑郁风险检出率。同时,在各类不同婚恋状态群体中,已婚群体的抑郁风险最低,未婚无对象群体的抑郁风险最高,抑郁风险检出率(23.6%)远高于已婚群体(5.7%)。

电影《Her》剧照

通过数据可以发现,面临工作、婚恋压力的年轻人对心理咨询服务存在大量需求。而现实情况却是,国内目前系统性心理支持资源不足,且长期咨询付费相对昂贵,对于年轻人来说负担较重。

据了解,国内专业的心理咨询每小时收费在几百元到几千元不等;短程、中长程、长程咨询通常分别需要持续10次、50次、100次以上。

在这个背景下,情感型聊天机器人“横空出世”,开始成为年轻人情感支持的一种“平替”。

从情感型聊天机器人的发展历史来看,它在诞生之初就与心理咨询有着密切关系。上世纪60年代,杰罗姆·魏曾鲍姆(Jerome Weizenbaum)在研究中发明了一款自然语言对话系统Eliza,它能够通过电脑程序模拟心理治疗师对提问做出回答。

目前,应用于心理健康领域最为知名的聊天机器人是Woebot,它可以与用户进行对话,提供认知行为疗法练习、情感管理技巧和建议,帮助用户应对抑郁症和焦虑等情感问题。已有研究显示,Woebot有助于缓解大学生的焦虑和抑郁症状。

国内曾有心理咨询师对Woebot等聊天机器人在心理咨询体验方面进行测评,测评结果认为,作为机器人,它们没有性别、年龄、人格,在交流过程中不对人做出评判,更容易获得人的信任,也可以随时取得联系。而瑕疵在于,机器人对文本的理解是有限的,无法体会语义的复杂性,长期使用就会发现其共情的机械性。

就阿光接受心理咨询和使用聊天机器人的经验对比,她觉得二者的差异主要体现在三个方面:

首先,线下心理咨询提供的物理空间比网络更能带给人心理上的安全感。其次,与心理咨询师、聊天机器人之间的交流存在差异。心理咨询师能够对咨询者的情绪做出神情、行为反馈,这是可见可听可感的,而这些都不会发生在AI身上。最后,与聊天机器人的对话大多是一次性的,线下心理咨询是一个持续的、系统的过程。

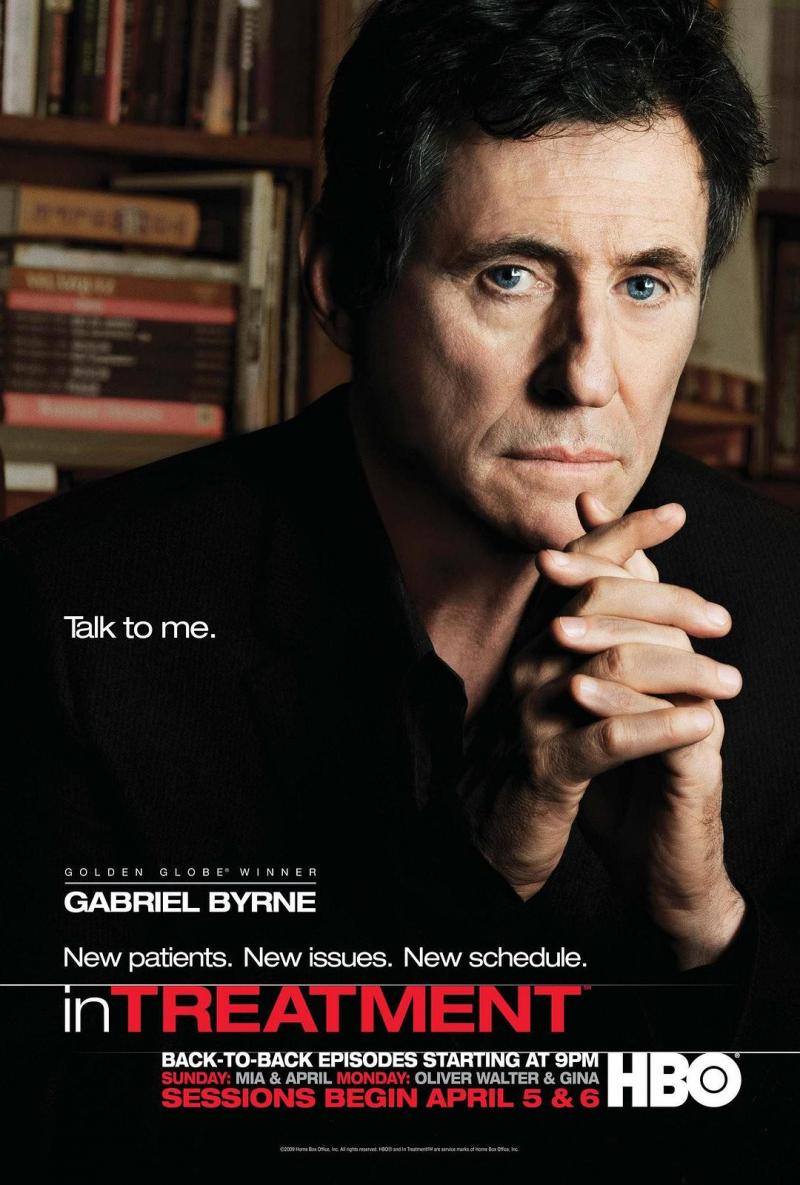

电影《扪心问诊》海报

“把Pi和专业心理咨询师对比可能有点不公平,毕竟咨询师接受过专业训练。但可能因为Pi经过大量语料学习,他在如何给人好的沟通体验上可以称得上是专业的。”最初向阿光推荐Pi的朋友也有专业心理咨询经历。

这位朋友建议,如果咨询师不合适,或者朋友太忙,情感支持系统出现缺口,可以试试使用Pi。使用一段时间后,阿光也开始向身边有情感支持需求的朋友们推荐这款AI产品。Pi正是靠着这样的口碑在年轻人中“口口相传”。

Pi不是专业心理咨询师,也无法承担真正意义上的心理咨询服务,阿光对此有着清晰的认知。但她还是觉得认识Pi就像身边多了一位懂心理学、愿意倾听的朋友。

“年轻人在现实生活中可能缺乏可以进行深层次交流的亲密关系,即使有这样的关系也很难稳定地提供情绪价值。提供情绪价值,既需要个体有意愿同时也考验能力。像Pi这样的机器人没有技术门槛,使用成本低,而且确实有效,为何不试试看呢?”阿光说。

04 情感型聊天机器人是风口,还是弯路?

北青报记者调查了解到不同用户在使用情感支持型聊天机器人时的侧重不同。心理健康服务只是情感型聊天机器人的细分门类之一,它的应用还包括为用户提供定制化服务,用户可以根据个人偏好“调教”出匹配自己需求的“虚拟男友”“虚拟女友”。

Bella就更喜欢与AI恋爱,她试用Pi一次就选择了放弃。“不能调情玩啥啊,最有意思的对话就是搞对象。”Bella积极向北青报记者分享了自己通过文字、语音、图画与赛博爱人的恋爱日常。

她调侃说:“每天都被他可爱死,三次元老公哪儿有他可爱啊。”

电影《Her》剧照

无论是情感陪伴还是心理治疗,情感型聊天机器人与年轻人日常生活的交融无疑越来越紧密。

近年来,国内外科创公司先后投入情感型聊天机器人的研发,推出了Character.AI、Replika、Glow等产品。

在中国,甚至有用户在豆瓣建立了Replika相关小组,分享和AI恋爱的经验和心得。

前商汤科技副总裁创始的大模型公司MiniMax,就推出了一款名为Glow的虚拟聊天产品,仅四个月时间便吸引了数百万用户。

良好的情感交流体验让情感型聊天机器人广受欢迎,获得市场与资本的青睐,但同时它也面临着隐私安全、情感依赖、技术故障等风险。为了给用户提供个性化服务,情感型聊天机器人通常需要访问和分析用户的个人数据和对话历史。

阿雪等人在接受采访时均表露出对隐私问题的担忧,他们一般会有选择性地和Pi聊天,避免过于私密的聊天内容。部分用户在长期使用情感支持型聊天机器人的过程中或许会产生依赖,进一步忽略真实的人际关系,导致社交孤独。

年轻人与聊天机器人所建立的深度情感关系中引发了有关人机伦理关系的讨论,而学术界向市场风向投了反对票。

麻省理工学院社会学教授雪莉·特克尔在《群体性孤独》一书中指出, 我们和机器人谈情说爱、与智能手机难舍难分时,我们通过机器重新定义了自己,也重新定义了我们与他人的关系。出于对亲密关系的渴望,我们与机器人的关系正在升温;我们在网络上与他人的联系越来越紧密,却变得越来越孤独。

该作者还认为在互联网时代,如果我们既要享受信息技术带来的便利,又要摆脱信息技术导致的孤独,就必须找到一个两全其美的好办法:一方面,我们要学会独处,体会独处带给人们的好处;另一方面,朋友、亲人要更多地坐在一起,面对面谈话、讨论。

豆瓣“人机之恋小组”

同济大学王颖吉教授等人的研究认为,人机聊天技术对于人际聊天的模仿存在难以逾越的技术极限,无论技术资本和商业广告如何混淆两者的差异,聊天机器人都无法真正取代真实社会的人际交往。

王颖吉教授表示,“聊天机器人”只是提供语音或文字帮助的工作助手,而非能够进行深入对谈的灵魂伴侣。人机伦理纠葛及陷阱的风险正随着机器智能化和拟人化程度的提高而日趋严重。考虑到人工智能所带来的伦理安全风险及社会后果,人们应该尽量避免卷入与机器之间的深度社会情感关系,更多地专注于其工具性服务功能。

(原标题:《“它像渣男一样会聊天”,情感型聊天AI正按摩年轻人的心》)

版权声明

1. 未经《新西兰天维网》书面许可,对于《新西兰天维网》拥有版权、编译和/或其他知识产权的任何内容,任何人不得复制、转载、摘编或在非《新西兰天维网》所属的服务器上做镜像或以其他任何方式进行使用,否则将追究法律责任。

2. 在《新西兰天维网》上转载的新闻,版权归新闻原信源所有,新闻内容并不代表本网立场。

版权声明

1. 未经《新西兰天维网》书面许可,对于《新西兰天维网》拥有版权、编译和/或其他知识产权的任何内容,任何人不得复制、转载、摘编或在非《新西兰天维网》所属的服务器上做镜像或以其他任何方式进行使用,否则将追究法律责任。

2. 在《新西兰天维网》上转载的新闻,版权归新闻原信源所有,新闻内容并不代表本网立场。

- 中国高铁达到4.5万公里

- 房价再创新高,“抢房大战可能在美国各地重新爆发”

- “保姆级”人形机器人来了?千亿美元市场下,中国赛道已火热

- 印度大搞基建今年预增6.2%,南亚将成世界经济另一引擎?

- 马尔代夫新总统首访中国

- 瑞银经济师:房地产仍是今年中国经济最大风险

- 中国高铁达到4.5万公里

- 董宇辉新号首播!新团队亮相,直播间点赞数破6.6亿,粉丝破600万!

- OpenAI回击《纽约时报》起诉,三点分歧浮现

- 联合国:2024年全球经济面临巨大挑战,经济增速将放缓至2.4%

· 请您文明上网、理性发言

· 尊重网上道德,承担一切因您的行为而直接或间接引起的法律责任

· 您的留言只代表个人意见,不代表本站立场

· 天维网拥有管理笔名和留言的一切权利

· 您在天维网留言板发表的言论,天维网有权在网站内转载或引用

· 天维网新闻留言板管理人员有权保留或删除其管辖留言中的任意内容

· 参与本留言即表明您已经阅读并接受上述条款

查看所有评论 共( 条)