OpenAI首席科学家出走背后:人工智能安全治理让位于“夺人眼球的产品”?

作者: 澎湃新闻 日期:2024-05-21 13:29 阅读:0 来源:澎湃新闻

据澎湃新闻报道,在伊尔亚·苏茨克维宣布告别后,原OpenAI超级对齐负责人杨·莱克在内的多名OpenAI核心成员也纷纷离职。从杨·莱克的推文中可以看到,OpenAI高层对人工智能安全方面的优先等级产生了不同看法。

作为当下全球最受瞩目的人工智能公司,OpenAI的每个消息都引发了外界的极大关注,除了AI产品,还包括人事纷争。

5月18日,原OpenAI超级对齐负责人杨·莱克(Jan Leike)在社交网站发布13条推文,公开自己离开OpenAI的真正原因,其中提及对AGI安全治理问题优先级不如推出“闪亮的产品”的不满,以及算力资源的分配问题。几乎在同一时间,外媒报道称,OpenAI的超级对齐团队已经解散。

杨·莱克(Jan Leike)的个人社交平台

杨·莱克被认为是追随伊尔亚·苏茨克维(Ilya Sutskever)选择离职。5月14日,在重磅发布ChatGPT-4的超级升级版——GPT-4o后不到36小时,OpenAI联合创始人兼首席科学家伊尔亚·苏茨克维在社交平台上宣布离职,而这并不令人意外,甚至算得上是从去年到今年该公司"宫斗"的一个暂时性完结,看上去以伊尔亚·苏茨克维为代表的理想派输给了以OpenAI CEO山姆•奥特曼(Sam Altman)为首的现实派。

在苏茨克维离职后,包括杨·莱克在内的多名OpenAI成员也纷纷离职。“OpenAI正在失去最优秀、最注重安全的人才。”大家在留言中表达惋惜。

人工智能公司 OpenAI 首席执行官山姆•奥特曼(左)与该公司前联合创始人兼时任首席科学家伊尔亚·苏茨克维于 2023 年 6 月 5 日在特拉维夫大学共同发表演讲。图:法新社

天才

苏茨克维在告别信息中写道,“在 Sam、Greg、Mira 和 Jakub 出色的领导下,我相信OpenAI将构建出既安全又有益的AGI。能够一起工作是我的荣幸,我会非常想念大家。”他也在推文中透露,自己对未来“充满期待”,“一个对我个人意义重大的项目,我会在适当的时候分享详细信息。”

关于苏茨克维离开的猜测始于2023年11月发生的OpenAI董事层一场戏剧性变化,先是奥特曼被宣布遭到解雇,但又迅速回归。据传"宫斗"的导火索,正是苏茨克维与奥特曼在AI安全、技术发展速度以及公司商业化问题上存在分歧。苏茨克维的关注点从来不是OpenAI的商业化,而是如何防止超级智能失控。

与奥特曼不同,苏茨克维不认为自己是一个公众人物,也鲜少接受媒体的采访。在麻省理工科技评论(MIT Technology Review)去年10月的一次采访中,记者威尔·道格拉斯(Will Douglas)描述他:“说话时从容、有条理。当他思考自己想说的内容以及如何表达时,他会停顿很长时间,像解谜一样翻来覆去地思考问题。他似乎对谈论自己不感兴趣。”

而在谈论人工智能,以及他所看到的划时代的风险和回报时,这位记者说道:“话题一下子就开阔了起来。” 苏茨克维谈道,他的新优先事项不是构建下一个 GPT或图像制作器 DALL-E,而是找出如何阻止人工智能的失控。

“苏茨克维低着头,陷入了沉思。他手指张开在桌面上,就像音乐会钢琴家即将弹奏他的第一个音符一样。我们静静地坐着。”道格拉斯在报道中写道,“即便在没有OpenAI的世界中,苏茨克维仍将载入人工智能史册。”

苏茨克维是以色列裔加拿大人,1986年出生于俄罗斯西北部的诺夫哥罗斯,从5岁到16岁,他一直居住在以色列耶路撒冷,会说俄语、希伯来语和英语,随后他移居加拿大,在多伦多大学跟随人工智能先驱杰弗里·辛顿 (Geoffrey Hinton) 学习并获得计算机科学博士学位。在他攻读博士期间,大多数人工智能研究人员认为神经网络是一个死胡同。苏茨克维恰恰相反,他对大脑很着迷。苏茨克维好奇,神经网络如何学习,以及如何在机器中重新创建或至少模仿该过程。在跟随辛顿学习期间,他看到了神经网络的潜力以及用来训练神经网络的试错技术,即深度学习。这是生成式人工智能的开始。

2012年,苏茨克维、辛顿与辛顿另一位名为亚历克斯的研究生,共同开发了名为 AlexNet的神经网络并凭借该网络赢得了2012年大规模视觉识别挑战赛(ILSVRC)的冠军。在这场比赛中,参赛者需要完成一个名叫“object region”的任务,即给定一张包含某目标的图像和一串目标类别(如飞机、瓶子、猫),每个团队都需要识别出图像中的目标属于哪个类。

AlexNet在比赛中颠覆性地将分类错误率降至了16.4%,这是获胜团队首次使用一种名为“卷积神经网络(CNN)”的深度学习架构。由于表现过于惊艳,之后几年的ImageNet挑战赛冠军都沿用了CNN。这是计算机视觉史上的一个关键时刻,许多人认为这代表着深度学习的复兴。

ImageNet 挑战赛冠军团队的分类错误率逐年变化情况(越低越好)

追求

在AlexNet大获成功后,谷歌收购了辛顿的衍生公司DNNresearch并聘请苏茨克维担任谷歌深度学习研究团队Google Brain的研究科学家。苏茨克维很快展现出在人工智能、深度学习领域的非凡天赋,他将深度学习的模式识别能力应用于数据序列,创建了序列到序列(Seq2seq)学习算法,深度参与了TensorFlow的研究,也是AlphaGo论文的众多作者之一。

2014年,苏茨克维被招募成为OpenAI的联合创始人。当时OpenAI还是一个非营利的人工智能研究实验室,旨在推动人工智能技术的发展,同时确保其安全性和普及性,苏茨克维认为这是一个认真追求人类通用智能(AGI)的机会。

“我记得奥特曼称苏茨克维为世界上最受尊敬的研究人员之一。” Y Combinator投资董事总经理道尔顿·考德威尔(Dalton Caldwell)说,“他认为苏茨克维能够吸引很多顶尖的人工智能人才。他甚至提到,世界顶级人工智能专家之一约书亚·本吉奥(Yoshua Bengio)认为,不太可能找到比苏茨克维更好的候选人来担任Open AI的首席科学家。”

OpenAI联合创始人格雷格·伯克曼(Greg Brockman)称赞他是一位“脚踏实地的人”、“清晰的技术专家”、“拥有广博的知识和远见”,而且“总是能够深入研究当前系统的局限性和功能的细节”。

2016年,Open AI的第一个GPT大语言模型诞生,此后的人工智能技术发展如坐上了火箭,先后出现了GPT-2、GPT-3、DALL-E,而每一次的迭代升级背后,都有苏茨克维的身影。

“你和其他研究人员有什么不同?为什么你能在你的领域取得多项突破?”在与知名科技播客主持人德瓦克什·帕特尔(Dwarkesh Patel)的对谈中,苏茨克维曾被这样问道。

“谢谢你的夸奖。这个问题很难回答。”他的答案是,“我真的很努力,我付出了我所拥有的一切,到目前为止,这一切都很有效。我想这就是全部了。”

分歧

裂痕产生于苏茨克维与奥特曼二人在AI技术突破的应用上产生的分歧。2023年6月,苏茨克维与奥特曼在特拉维夫大学同台对谈时,主持人提到AI存在三个风险:工作岗位受到影响、黑客获得超级智能和系统失控,二人回答有微妙的不同。苏茨克维承认并强调AI存在风险,非常看重“AI对齐”(用人类的反馈来训练模型,让其遵守人类的价值观)的重要性。

尽管奥特曼也同意AI失控的风险且需要不同的社会经济契约来制衡,但他更倾向描述AI乐观的一面。媒体分析认为,二人之间分歧的根源在于如何理解自己正在创造的东西,以及如何达成AGI(通用AI)的方式。

苏茨克维曾在麻省理工科技评论的采访中表达了他对AI可控性的忧虑:一旦人工智能的水平超过人类,人类又该如何监督比自己聪明得多的人工智能系统?

“我们在AlphaGo中看到了一个非常狭隘的超级智能的例子。”苏茨克维提到了AlphaGo的第37步棋。在与李世石的第二场比赛中,人工智能的一步棋让评论员感到困惑,他们认为AlphaGo搞砸了,事实上,它下了棋史上从未见过的制胜棋。“想象一下这种程度的洞察力,但涵盖一切。” 苏茨克维说。

苏茨克维认为,如果AI按照现有路径发展下去,也许在不久的将来,一个超越人类的人工智能系统就会诞生。但更加令人担心的是,“超级人工智能”可能会带来一些意想不到的负面后果。

正是这种思路导致苏茨克维做出了他职业生涯中最大的转变。在他的努力下OpenAI在2023年7月成立了“超级对齐”(Superalignment)团队,目标是在四年内解决超智能AI的对齐问题。苏茨克维是该项目的牵头人之一,OpenAI表示会将20%的算力专门用于该项目的研究。

超级对齐团队的第一篇成果发布于2023年12月——使用GPT-2级别的小模型来监督GPT-4级别的大模型,能获得接近GPT-3.5级别的性能,开辟了对超人类模型进行实证对齐的新研究方向。

该项目的公布不可避免地引发了巨大的争议,甚至引起了大型科技公司著名批评者的蔑视。但就苏茨克维而言,超级对齐是下一步不可避免的事情。“这是一个尚未解决的问题,”他说,“很重要、很明确的是要保证,任何人构建的任何超级智能都不会失控。”

让位

显示分歧激化的"宫斗"发生在2023年11月20日。当日,OpenAI官网突然宣布将奥特曼及联合创始人格雷格·布罗克曼除名。OpenAI在公告中称奥特曼对董事会不够坦诚。

有人将其解读为:OpenAI可能已经在内部实现了AGI,但并没有将消息及时同步给更多人员,为了防止该技术未经安全评估就被大规模应用,苏茨克维等人按下了紧急停止键。

在奥特曼突然被辞退后,员工和投资者出现了极大反弹,投资者也奋起反抗。几天后OpenAI约770名员工几乎全部联名上书,如果不让奥特曼复职,他们就集体辞职。

情急之下,苏茨克维表示反悔,在一封要求奥特曼回归的员工信上签了字,并对自己参与董事会的行为“表示遗憾”。经历5天的董事会政变后,奥特曼在2023年11月29日正式回归OpenAI,重新担任CEO,同时宣布OpenAI的董事会将迎来重组。苏茨克维没有立即离开OpenAI,但也没有再出现在OpenAI旧金山的办公室。

在发布离职的推文前,苏茨克维在社交平台X上的最后一条动态,停留在2023年12月15日转载超级对齐团队拨款的文章。

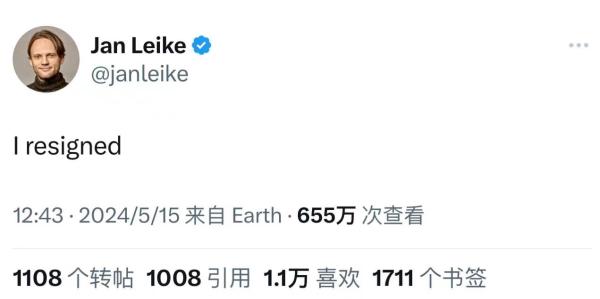

在苏茨克维正式宣布离开OpenAI后,苏茨克维的追随者、他在超级对齐团队的共同领导者杨·莱克也随后宣布离职,称“I resigned(我已辞职)”。

杨·莱克宣布离职的推文

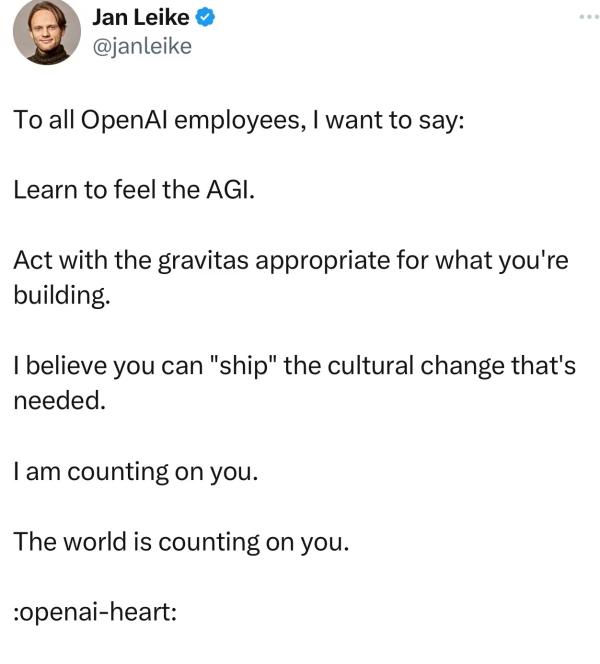

他在上周五(当地时间5月17日)连发13条推文,公开了他离职的原因:

“很长一段时间以来,我与OpenAI领导层对公司核心优先事项的看法一直不合,直到我们终于到了临界点。

我认为,我们应该把更多的带宽用于为下一代模型做好准备,包括安全性、监控、准备、对抗鲁棒性、(超级)一致性、保密性、社会影响和相关主题。

……过去几个月里,我的团队一直在逆风航行。有时我们在计算上很吃力,完成这项重要的研究变得越来越困难。

建造比人类更聪明的机器本身就是一项危险的尝试。

OpenAI代表着全人类肩负着巨大的责任。

但过去几年,安全文化和流程已经让位于吸引眼球的产品。……”

对此,奥特曼发文回应,称“我非常感激杨·莱克对OpenAI的对齐研究和安全文化做出了贡献,看到他离开,我感到非常难过。他说得对,我们还有很多事情要做;我们致力于这样做。在接下来的几天里,我会有一个更长的帖子。”

几个月来,OpenAI一直在流失关注AI安全的员工。自去年11月至今,OpenAI至少有7名注重安全的成员辞职或被开除。据《连线》证实,OpenAI超级对齐团队已经解散,余下成员要么辞职,要么将被纳入OpenAI的其他研究工作中。

据Vox报道,安全意识强的员工已经对OpenAI在 AGI 时代会负责任地行事失去了信心。

丹尼尔·科科塔伊洛(Daniel Kokotajlo)于2022年加入OpenAI,一直负责AI安全治理工作直到上个月辞职。“OpenAI正在训练越来越强大的AI系统,目标是最终全面超越人类智能。这可能是人类有史以来最好的事情,但如果我们不谨慎行事,也可能是最糟糕的事情,”科科塔伊洛说,“我加入时满怀希望,希望OpenAI能够迎难而上,在他们越来越接近实现AGI的过程中表现得更加负责任。我们中的许多人逐渐意识到这不会发生。”

更多人在这场离职风波后,开始关注AI安全问题。超级对齐团队结束后,现在这些计算能力可能会被转移到其他OpenAI团队,目前还不清楚是否会将重点放在避免未来AI模型的灾难性风险上。尽管这并不意味着OpenAI现在发布的产品将会毁灭人类,但OpenAI是否正在安全地部署和构建人工智能,未来如何保障人工智能的安全性,都是此次离职风波过后,苏茨克维留下的问题。

版权声明

1. 未经《新西兰天维网》书面许可,对于《新西兰天维网》拥有版权、编译和/或其他知识产权的任何内容,任何人不得复制、转载、摘编或在非《新西兰天维网》所属的服务器上做镜像或以其他任何方式进行使用,否则将追究法律责任。

2. 在《新西兰天维网》上转载的新闻,版权归新闻原信源所有,新闻内容并不代表本网立场。

版权声明

1.

未经《新西兰天维网》书面许可,对于《新西兰天维网》拥有版权、编译和/或其他知识产权的任何内容,任何人不得复制、转载、摘编或在非《新西兰天维网》所属的服务器上做镜像或以其他任何方式进行使用,否则将追究法律责任。

2. 在《新西兰天维网》上转载的新闻,版权归新闻原信源所有,新闻内容并不代表本网立场。

- 站在AI风口的创业者:从“复活”到“复刻”,有哪些思考和挑战

- 南京挂牌3宗涉宅用地,起拍总价19.7亿元

- 中国科学院脑科学公众科学日,用科普埋下种子

- 伊朗总统坠机遇难,直升机遇险背后是天灾还是人祸?

- 伊朗总统坠机细节公开:“在空难发生几分钟内离世”

- 伊朗总统莱希在直升机事故中罹难

- “没有人员生还迹象” 伊朗总统所乘直升机已被发现

- 伊朗总统乘坐直升机“坠机”,搜救队赶赴现场

- 美国警方公布波音“吹哨人”死因

- 古巴对中国公民短期来古免签政策正式生效

· 请您文明上网、理性发言

· 尊重网上道德,承担一切因您的行为而直接或间接引起的法律责任

· 您的留言只代表个人意见,不代表本站立场

· 天维网拥有管理笔名和留言的一切权利

· 您在天维网留言板发表的言论,天维网有权在网站内转载或引用

· 天维网新闻留言板管理人员有权保留或删除其管辖留言中的任意内容

· 参与本留言即表明您已经阅读并接受上述条款

查看所有评论 共( 条)